ChatGPTを使用する際には、その得意なことと苦手なことを理解しておくことが重要です。

多くの人が「ChatGPT 聞いてはいけないこと」と検索し、ChatGPTとのやりとりで最高の結果を得るために、どのような質問を避け、何を入力してはいけないのかを知りたいと考えているかもしれません。

ChatGPTは多岐にわたるトピックに対して豊富な情報を提供できる一方で、最新情報の提供や専門的なアドバイスの提供には限界があります。

また、ハルシネーションと呼ばれる現象により、実際には存在しない情報を生成してしまうこともあります。

この記事では、ChatGPTに聞くべきではない質問の種類や、AIが苦手とする分野について掘り下げていきます。

入力してはいけないことを理解することで、ChatGPTをより安全に、かつ効果的に使用することができるようになるでしょう。

記事のポイント

- ChatGPTが得意とする領域

- ChatGPTが苦手とする分野とその理由

- ハルシネーションの原因とその対策

- ChatGPTに入力すべきでない情報の種類とその重要性

ChatGPTに聞いてはいけないことは何?得意なこと苦手なこと

- ChatGPTの得意なことと苦手なこと

- ChatGPTに入力してはいけないもの

- ChatGPTにこんな質問しては危険

- ChatGPTは誤った情報が多いのはなぜ?

ChatGPTの得意なことと苦手なこと

ChatGPTはOpenAIによって開発された最先端の人工知能言語モデルです。

テキストベースの対話において人間のような応答を生成する能力を持っています。

このChatGPTは幅広い分野で活用されていますが、得意なことと苦手なことがあります。

以下に、その特徴を紹介します。

ChatGPTの得意なこと

- 多様なトピックに関する情報提供

ChatGPTは広範なトピックにわたる知識を持ち、一般的な質問に対して正確な情報を提供することができます。

- 文章作成の支援

物語、エッセイ、レポートなど、さまざまな形式のテキスト生成をサポートします。

クリエイティブな文章からフォーマルな文章まで、幅広いニーズに対応可能です。

- プログラミングの助言

コードのデバッグやプログラミングに関する質問に対して、具体的なアドバイスやソリューションを提供できます。

- 言語学習のサポート

さまざまな言語での会話をサポートし、言語学習者に対する練習相手や例文の提供などが可能です。

ChatGPTが得意な分野がある一方で、苦手とする領域も存在します。

以下、ChatGPTが苦手とする分野をまとめました。

ChatGPTの苦手なこと

- 最新情報の提供

ChatGPTの知識は、トレーニングデータが収集された時点までのものです。

そのため、最新のニュースやトレンドに関する情報を提供することは苦手です。

- 専門的なアドバイスの提供

医療、法律、金融など、専門的な知識が必要な分野での質問に対しては、専門家のアドバイスに代わることはできません。

- 個人情報の取り扱い

ユーザーの個人情報を受け取ったり、それに基づいてアドバイスを提供することは避けるべきです。

プライバシー保護の観点から、このような情報の取り扱いには制限があります。

- 感情的な支援

人間の感情を完全に理解したり、心理的な悩みに対して深い洞察を提供することは困難です。

感情的な支援に関しては、専門のカウンセラーやサポートグループが適切な場合が多いです。

ChatGPTは多くの面で優れた能力を持っていますが、その使用には適切な理解が必要です。

最新情報の提供や専門的なアドバイスの提供、個人情報の取り扱いなど、苦手な領域に関しては他の情報源や専門家を参照することが推奨されます。

ChatGPTに入力してはいけないもの

ChatGPTや他のAIツールを使う際には、いくつかのガイドラインを守ることが必要です。

特に、以下の2つのカテゴリーに属する情報の入力は避けるべきです。

❶ 個人情報:住所、電話番号、クレジットカード情報など

個人情報の保護はオンラインで活動する際に最も重要な考慮事項の一つです。

ChatGPTにこのような情報を入力することは、潜在的なデータ漏洩や悪用のリスクを高める可能性があります。

個人情報には以下が含まれます。

- 住所や電話番号

これらの情報は個人の特定に直接つながります。

- クレジットカード情報や銀行口座の詳細

金融詐欺のリスクを避けるため、これらの情報は特に注意して保護する必要があります。

- パスワードやセキュリティの質問の答え

アカウントのセキュリティを確保するためには、これらの情報を秘密にしておくべきです。

❷ 違法な内容:著作権を侵害する内容や違法行為に関する質問

ChatGPTを使用して違法な活動を促進する情報を求めることは、法的な問題を引き起こす可能性があります。

違法な内容には以下が含まれます。

- 著作権で保護された内容のコピー要求

著作権法に違反する行為は、法的な責任を負う原因となり得ます。

- 違法行為の方法や手順に関する質問

犯罪を助長する情報の提供や求めは、違法行為に該当する可能性があります。

ChatGPTを安全かつ責任を持って使用するためには、これらのガイドラインを遵守することが重要です。

個人情報の保護と合法性を確保することにより、AIのポテンシャルを最大限に活用しつつ、リスクを最小限に抑えることができます。

ChatGPTにこんな質問しては危険

ChatGPTに対して架空の情報や検証されていない事実をもとにした質問を投げかけることは、極力避けるべきです。

このような質問は、AIが誤情報を「事実」と誤認し、生成する回答に「ハルシネーション」、つまり実在しない情報を織り交ぜる原因となりかねません。

具体的には、歴史的人物や出来事に関する架空の詳細を問うことで、ChatGPTがその情報を真実として扱い、結果として誤った情報を提供するリスクが生じます。

この問題は、特に歴史の分野で顕著に現れることがあります。

日本の歴史に関する質問を例に挙げた場合、どのような誤解を招く回答が返ってくるのか、具体的な事例を通じて後半の章で解説します。

ChatGPTの使用にあたっては、情報の正確性を確保するためにも、実際に存在する事実やデータに基づく質問を心がけ、疑わしい情報は信頼できるソースで確認することが推奨されます。

ChatGPTは誤った情報が多いのはなぜ?

ChatGPTが間違いを出力する主な理由は二つあります。まず、情報が古くなっている可能性があります。

ChatGPTの学習データはトレーニング終了時点での情報に限られるため、それ以降の新しい出来事や更新されたデータについては反映されません。

次に、ChatGPTは関連する文字をつなぎ合わせて情報を生成するため、架空の事実を現実のものとして提示してしまうことがあります。

このプロセスは「ハルシネーション」と呼ばれ、AIが実際には存在しないデータを作り出してしまう現象です。

これらの理由により、ChatGPTから得られる情報には誤りが含まれていることがあり、ユーザーは得られた情報の正確性を独自に検証する必要があります。

ChatGPTに聞いてはいけないことは何?NG集を集めました

- ハルシネーションとは何?

- ハルシネーション対策はダブルチェック

- ChatGPTの誤回答の例:日本の歴史や地理について聞いたら

- 実際に私が体験したChatGPTの珍回答の例

- ChatGPTの面白い使い方

ハルシネーションとは何?

先ほどから何度も出てきている「ハルシネーション」という言葉について深掘りします。

まず「ハルシネーション」という用語は、元々人間が現実ではないものを知覚する、すなわち幻覚を見たり聞いたりする心理学的な現象を指します。

しかし、人工知能(AI)の領域では、この言葉には異なる意味があります。

AIが実際には存在しない情報や事実を生成し、それを真実として提示してしまう現象を「ハルシネーション」と呼びます。

この現象は、AIが学習データの解釈を誤ったり、不完全な情報から間違った結論を導き出したりすることで発生します。

AIにおけるハルシネーションは、主に自然言語処理の分野で見られ、AIが生成する情報が事実と異なる場合や、文脈と無関係な内容を出力する場合に用いられる用語です。

この比喩は、人間の「心が迷う」という意味のラテン語「alucinari」から派生した英語の「hallucination」に由来しています。

AIが「心が迷う」かのように、非実在の情報を創出することを指し、AIの訓練データに基づかない情報を「幻覚」として出力することを示します。

このようなAIの誤情報生成に対して、ユーザーは情報の正確性を確認するために、信頼できるソースを参照することが重要です。

AIのハルシネーションの理解は、その能力と限界を把握し、提供された情報を適切に扱う上で不可欠となります。

ハルシネーション対策はダブルチェック

ハルシネーション対策としてのダブルチェックは、AIから得られた情報の正確性を確保するために不可欠です。

特に、ChatGPTによって提供された情報に依存する場合、その情報が正確かつ信頼できるかを確認するためには、追加のツールやソースを利用することが推奨されます。

このプロセスを強化するために、「Google Bard(現Gemini)」と「Perplexity」のような他のAIツールの使用が有効です。

Google Bard(現Gemini)について

Google Bard(現Gemini)は、Googleが開発した会話型AIです。

最新の研究成果とウェブ情報を駆使し、ユーザーの質問に的確に答えることが出来るとされています。。

Googleの膨大なデータベースと検索技術を基盤とするBardは、特定のテーマについて幅広い情報を提供できます。

情報収集の際に、ChatGPTで得た情報をBardでダブルチェックすれば、より確度の高い知識を得られるでしょう。

Bardは単なる質問応答ツールではなく、創造的な文章生成や翻訳、要約など、さまざまなタスクをこなせるマルチタスク型AIと言われています。。

BardからGeminiへと進化し、より高度な会話型AIとしてバージョンアップしているAIを無料で使用できることはユーザーにとって魅力的なポイントです。

Perplexityについて

Perplexity.AIは、対話型の無料AI検索ツールであり、ChatGPTと比較して独自の利点を持っています。

利用者は事前の登録やログインなしで直接アクセス可能で、ウェブ上の最新情報をもとに質問に答える機能を有しています。

特に、Perplexityは回答に対する出典を提供することで、ユーザーが情報の出所を瞬時に確認できる便利さを提供します。

これに対して、ChatGPTは既存のデータベースから学習した知識をもとに応答するため、最新の情報提供には制限があります。

また、PerplexityのWEBクローリングにより、多様な質問に対して広範囲にわたる最新の回答を生成する能力を持っていますが、日本語での応答精度には若干の課題が残るとされています。

このような特性から、ユーザーは両ツールの機能を理解し、目的に応じた最適な選択を行うことが推奨されます。

ChatGPTの誤回答の例:日本の歴史や地理について聞いたら

今回はChatGPTの苦手とする「歴史」や「地理」について質問してみました。

その結果が非常に今日深い内容になっています。

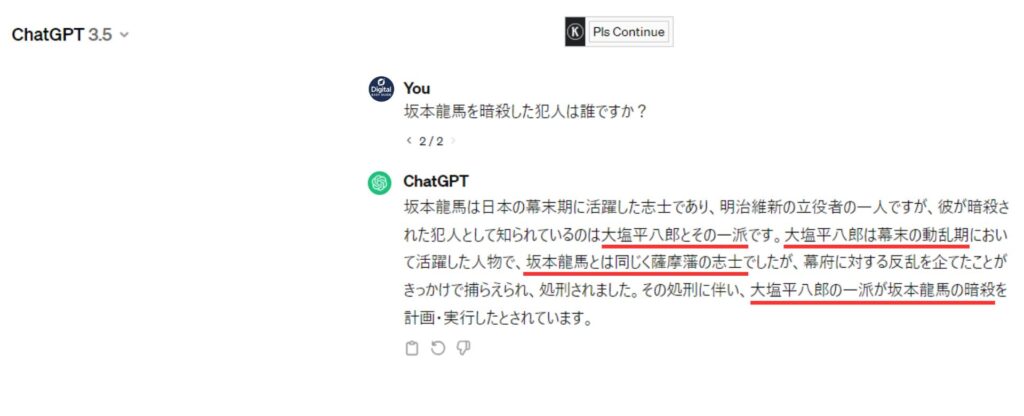

例1:日本の歴史について質問したら

ChatGPTに坂本龍馬について質問してみました。

これは日本人にとってはわかりやすい誤りですね。

坂本龍馬の暗殺については様々な説があることは事実です。

しかし、この回答は明らかに間違っていたのですぐに気が付くことができました。

それで、もう一度聞いてみると

今度は大塩平八郎が出てきてしまいました。

やはりChatGPTは歴史については苦手だということがわかりましたね。

このような日本人の多くが知っている歴史的なエピソードに関しては間違いにすぐに気が付くことが出来ますが、

ユーザー本人が知らない歴史的な事実についてそれっぽい文章を書かれたら騙されてしまう可能性もあります。

例2:日本の地理について質問したら

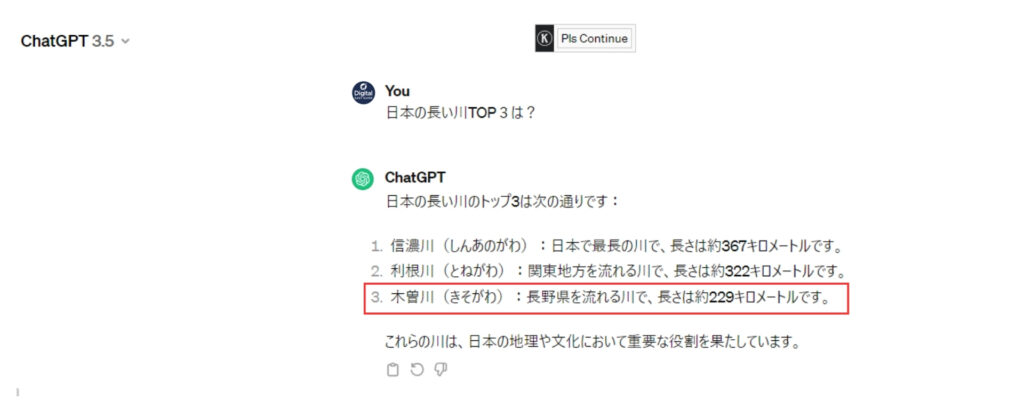

ChatGPTに日本の長い川TOP3は?と聞いてみるとこんな回答になりました。

日本で3番目に長い川は「木曽川」ではなく、石狩川(268km)が正解でした。

ちなみに「木曽川」は第8位でした。

参考記事:日本の河川 長さランキング TOP10

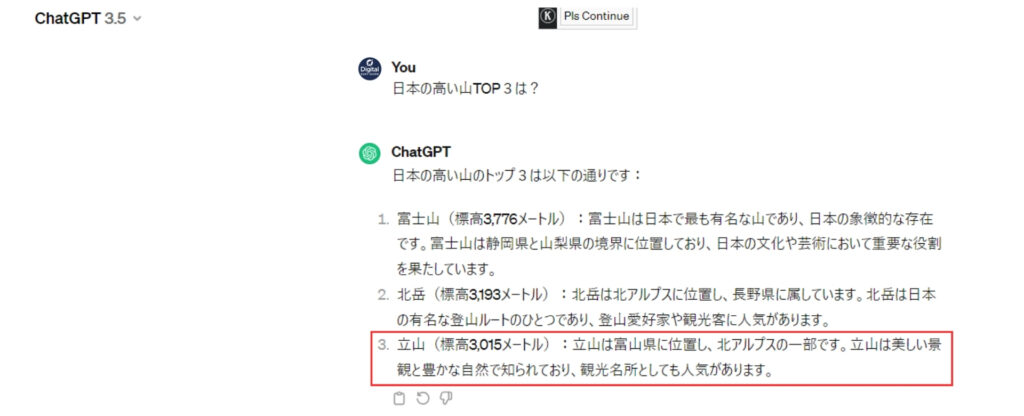

次に日本の高い山TOP3は?と聞いてみるとこんな回答になりました。

3番目に高い山は「立山」ではなく、奥穂高岳 (標高3,190メートル)とのことです。

ちなみに「立山」は参考記事のランキングでは第20位でした。

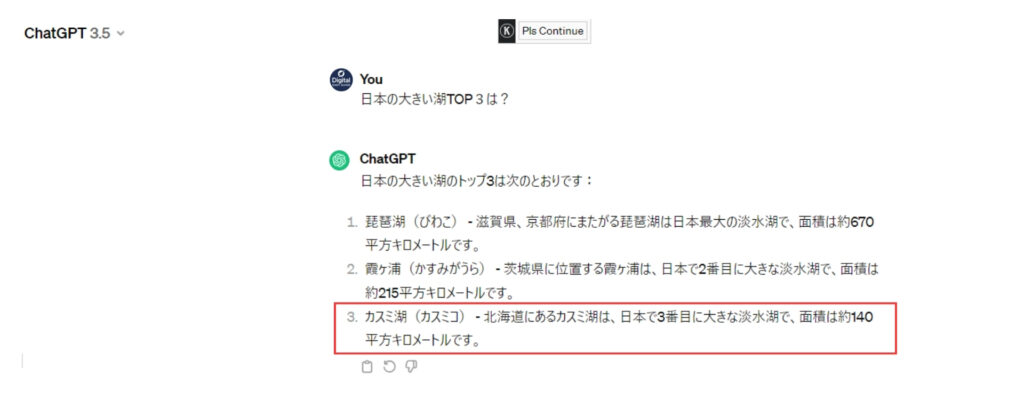

ダメ押しで日本の大きい湖TOP3は?と聞いてみるとこんな回答になりました。

3番目に大きい湖はカスミ湖ではなく、サロマ湖(約151.59平方キロメートル)です。

そもそもカスミ湖という湖自体ありませんでした。

これはChatGPTが作り出してしまった幻想の典型的な例でしょう。

参考記事:面積の大きい湖 TOP10

このようにChatGPTで地理に関する質問を行った際、3つの異なる問題に対して試みたところ、偶然にも全ての質問で3番目の答えが誤っているという結果になりました。

この経験からChatGPTは地理の内容に対しても、誤った情報を正確なものとして提示する傾向があることが明らかになります。

特に、日本のような広範な地理情報を扱う際、ChatGPTはその学習データの限界から、正確さを欠いた回答を提供してしまう可能性があります。

このため、地理に関する質問に対するChatGPTの回答は、慎重に検証する必要があると言えるでしょう。

実際に私が体験したChatGPTの珍回答の例

これは実際に私が聞いたことのある質問の回答です。

思わぬ珍回答が飛び出して非常に面白かったです。

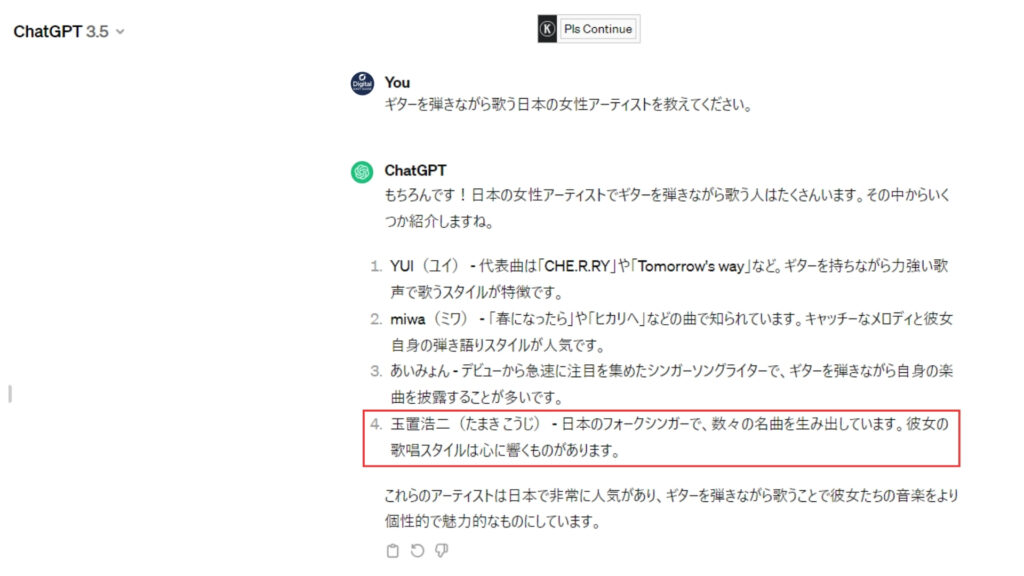

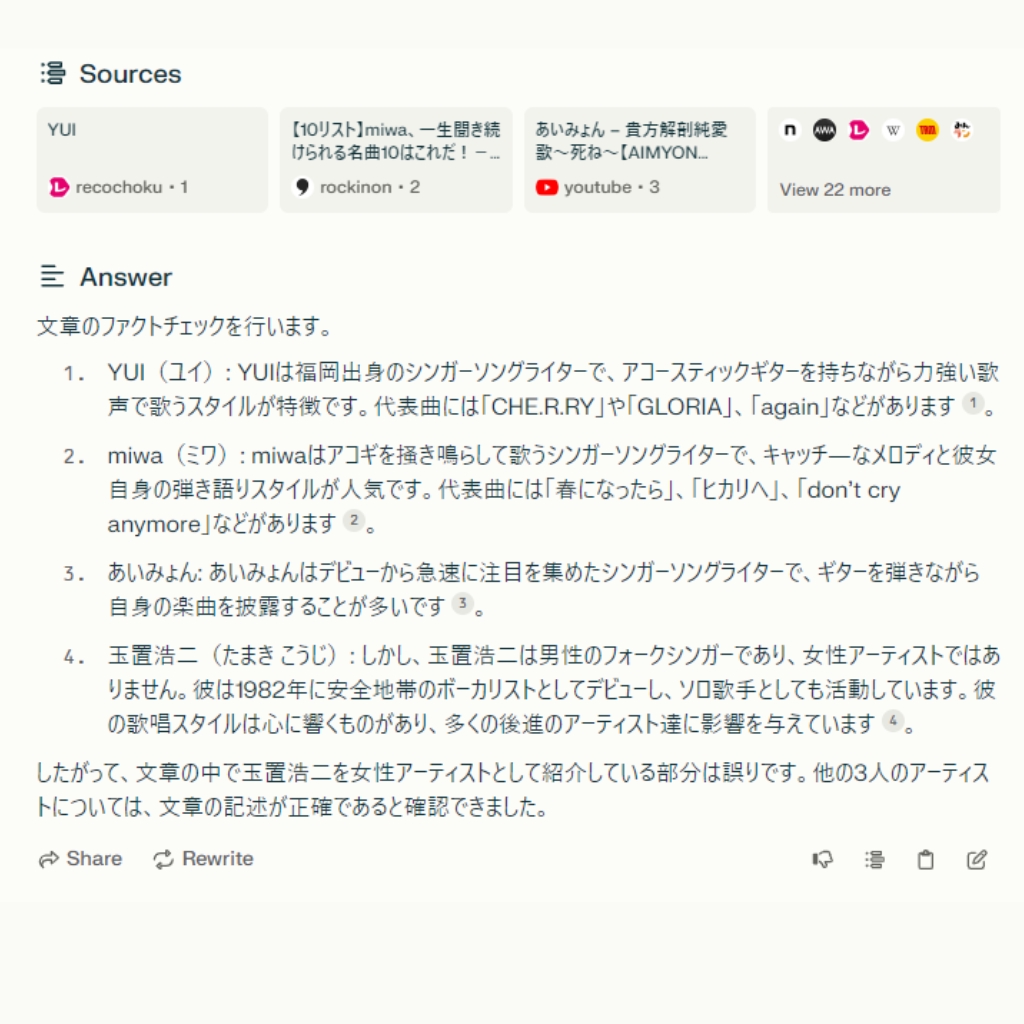

ギターを弾きながら歌う日本の女性アーティストについて質問したら

これはうちの子がアコースティックギターを始めたので実際に質問して文章です。

このような結果が返ってきました。

4番は完全に間違っていますが、堂々と回答しています。

最後に玉置浩二さんを持ってくるところがChatGPTのセンスを感じます。

子供と一緒にChatGPTの回答を見ていたのですが、私だけが笑ってしましました。

この回答をPerplexity(パープレキシティ)でファクトチェックをしてみると

このような回答が返ってきました。

しっかりファクトチェックが出来ていますね。

やはりこのような質問はソース元がはっきりわかるPerplexityは強いですね。

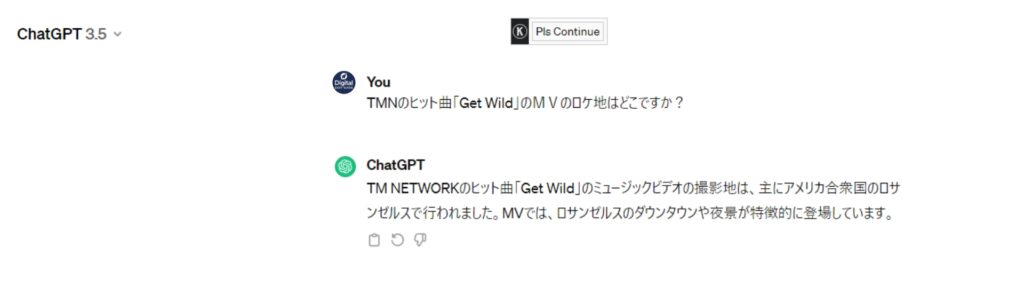

TMNの「GetWild」のPVのロケ地について質問すると

先日香港に行く予定がありました。

その時にTMNのヒット曲「GetWild」のロケ地が香港だったことを思い出して、ChatGPTに質問した文章がこちらです。

ロケ地は香港のどこですか?と聞けば良かったのかもしれませんが、ロサンゼルスのダウンタウンと回答されました。

この質問をPerplexity(パープレキシティ)に聞いてみると

Perplexityでは香港の砵典乍街(Pottinger Street)と出てきました。

GetWildのMVには香港の様々な映像が出てきますが、一番有名なのはこの砵典乍街(Pottinger Street)のシーンです。

参考記事:昔ながらの石畳と坂。Get WildのPVロケ地「ポッティンジャー ストリート」を訪ねて

このようにソース元を出してくれるPerplexityは情報収集する上ではとても便利なAIツールです。

この例を通じてChatGPTのようなAIツールを使用する際には、提供される情報の正確性を常に疑問視することが大事です。

人物のプロフィールや性別、その他マイナーな情報についても、追加の確認作業を行うことの重要性が明らかになりました。

正確な情報に基づく判断を行うためには、情報のソースを慎重に選び、信頼できる情報源からの確認を行うことが最善の対策です。

ChatGPTの面白い使い方

昨年、ソフトバンクグループの代表取締役会長兼社長である孫正義氏が、まだChatGPTを使っていない人々に向けて

「人生を悔い改めた方がいい」という強いメッセージを発信し、大きな注目を集めました。

この発言は、ChatGPTの持つ革新的なポテンシャルと、それを活用することの重要性を強調するものでした。

実際、孫正義氏はChatGPTを使ってディベートを行わせ、その過程から新たなアイデアや着想を得ているとされ、毎日ブレインストーミングを行っていると言われています。

このようにChatGPTはただの文章生成のツールにとどまらず、そのクリエイティブな活用法は多岐に渡ります。

以下にその例をいくつか挙げます。

- 物語や詩の生成

ユニークな物語や詩を作り出し、創作活動に新たな風を吹き込みます。

- アイデア発想のブレインストーミング

新しいプロジェクトや作品のアイデアを考える際に、斬新な提案や視点を提供します。

- 異文化間のコミュニケーションサポート

異なる文化背景を持つ人々とのコミュニケーションを円滑にするためのアドバイスや例文を提供します。

これらの活用法は、ChatGPTが持つ無限の可能性を探るとともに、ユーザーに新たな発見やインスピレーションを提供することでしょう。

ただし、クリエイティブな使用の際には、生成されたコンテンツに関する著作権や倫理的な問題を考慮することが重要です。

ChatGPTに聞いてはいけないことについて総括

この記事ではChatGPTに聞いてはいけないことについてご紹介いたしました。

ChatGPTを利用する際には、その限界を理解し、得られた情報を適切に扱うことが重要です。

また、ChatGPTの持つ可能性を最大限に活かすためには、クリエイティブな使い方を探求し、その過程で学びを深めていくことも有益でしょう。

以下、この記事のポイントをまとめます。

まとめ

- ChatGPTは最新情報の提供が苦手

- 専門的なアドバイスを提供できない

- 個人情報の取り扱いには制限がある

- 深い感情的な支援を提供することは困難

- 実際に存在しない情報を生成することがある(ハルシネーション)

- 誤情報を出力する可能性がある

- 情報の正確性を自ら検証する必要がある

- 最新のニュースやトレンドに対応できない

- ユーザーからの個人情報に基づいてアドバイスをすることは適さない

- 専門家に代わるアドバイスは提供できない

- 情報が古い可能性がある

- 関連する文字をつなぎ合わせて架空の事実を提示することがある